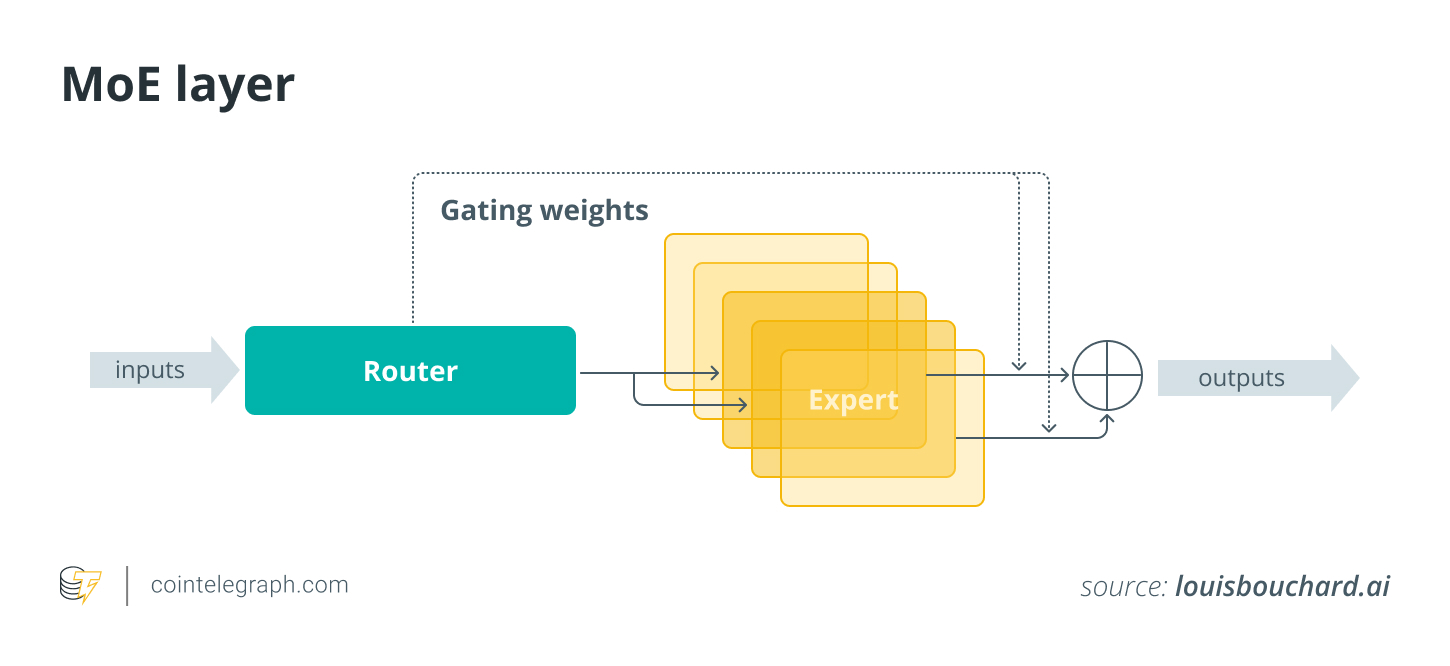

传统模型中,所有事情都由一个通用系统处理,该系统必须同时处理所有事情。MoE 将任务分派给专门的专家,使其更加高效。dMoE 将决策分散到较小的系统中,这在您处理大数据或大量机器时非常有用。

传统上,机器学习模型的工作原理是使用一个大型通用模型来处理所有事情。想象一下,一个专家试图处理每一项任务:它可能在某些方面还行,但在其他方面就不太好了。例如,如果你有一个模型试图在同一个系统中识别人脸和文本,那么该模型就必须同时学习这两项任务,这可能会使其速度变慢、效率降低。

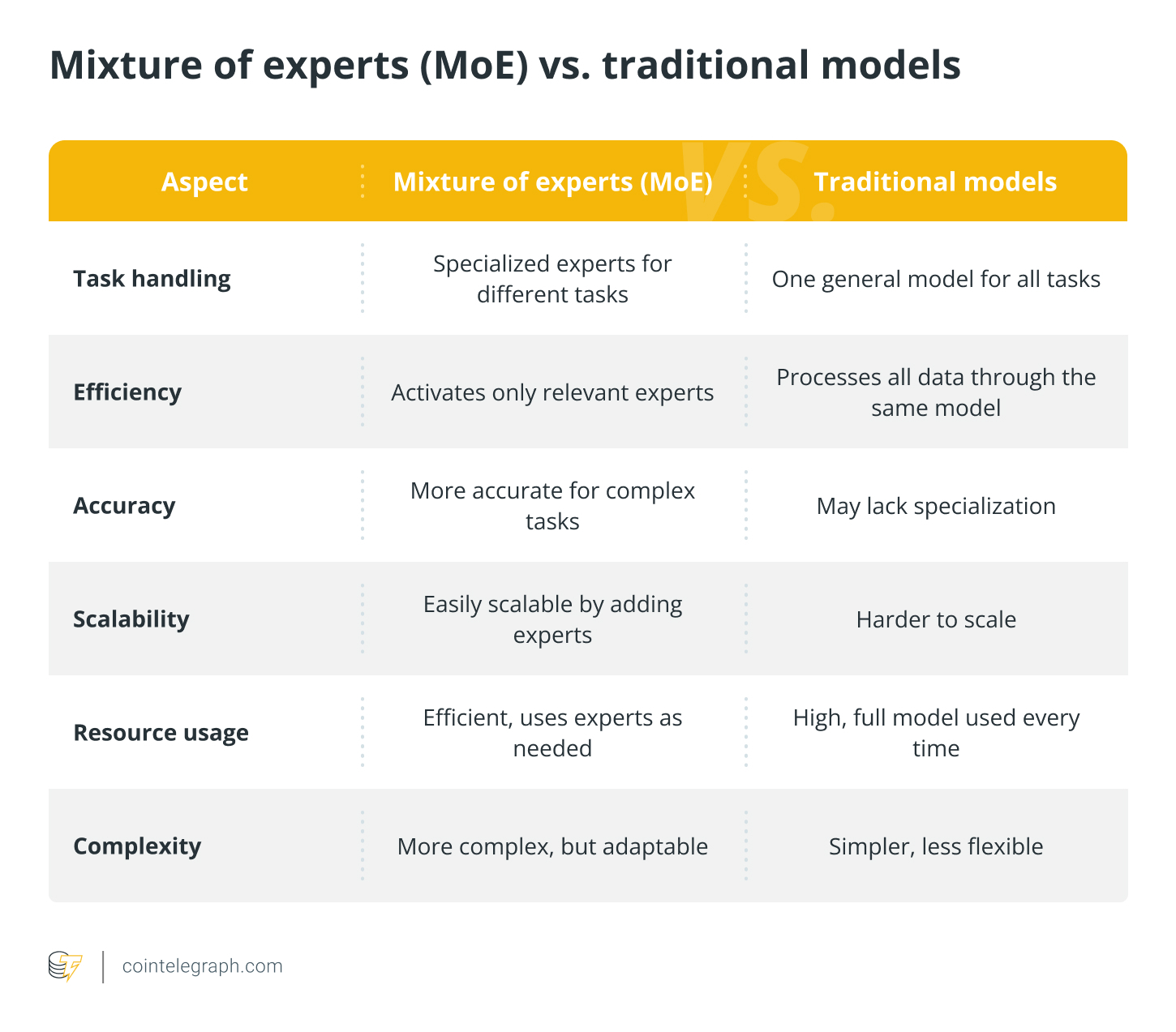

使用 MoE,您无需让一个模型尝试完成所有事情,而是将工作分解为更小的任务并专门化模型。可以将其想象成一家拥有不同部门的公司:一个部门负责营销,一个部门负责财务,一个部门负责客户服务。当收到新任务时,您会将其发送给相关部门,从而使流程更加高效。在 MoE 中,系统会根据任务需求选择使用哪位专家 — 因此速度更快、更准确。

去中心化混合专家系统 (dMoE) 则更进了一步。不再由一个中央“老板”决定使用哪个专家,而是多个较小的系统(或“门”)各自做出决定。这意味着系统可以更有效地处理大型系统不同部分的任务。如果您要处理大量数据或在许多不同的机器上运行系统,dMoE 可以帮助系统的每个部分独立工作,使一切更快、更具可扩展性。

MoE 和 dMoE 相结合,可以实现以更快、更智能、更具可扩展性的方式处理复杂任务。

关键的去中心化 MoE 组件

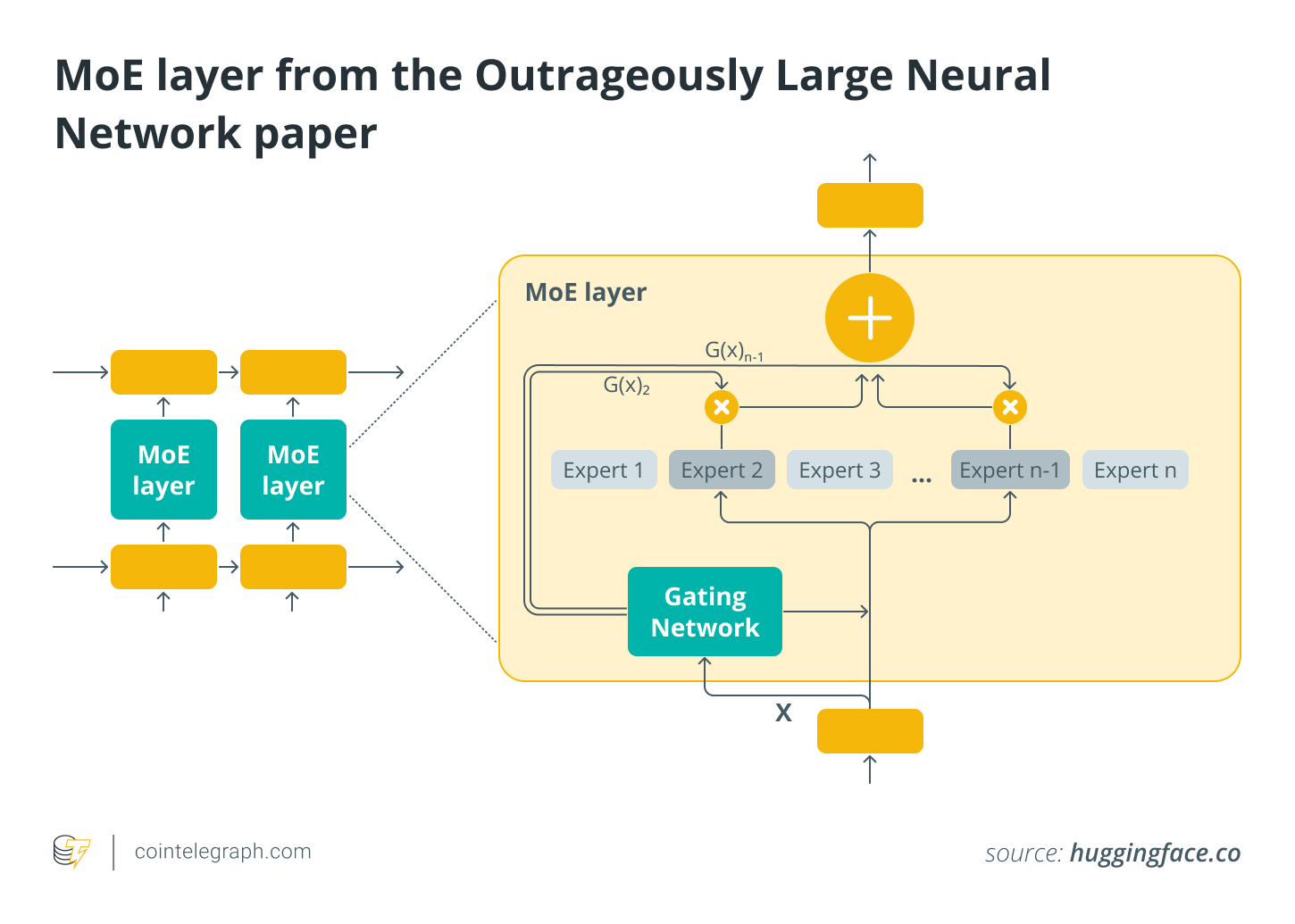

在 dMoE 系统中,多个分布式门控机制独立地将数据路由到专门的专家模型,从而无需中央协调器即可实现并行处理和本地决策,从而实现高效的可扩展性。

帮助 dMoE 系统高效运行的关键组件包括:

- 多个门控机制:不再由一个中央门控决定使用哪些专家,而是多个较小的门控分布在整个系统中。每个门控或路由器负责为其特定任务或数据子集选择合适的专家。这些门控可以被视为并行管理不同数据部分的决策者。

- 专家: dMoE 系统中的专家是针对问题的不同部分进行训练的专业模型。这些专家不会同时被激活。门会根据传入的数据选择最相关的专家。每个专家都专注于问题的一个部分,例如一个专家可能专注于图像,另一个专家专注于文本,等等。

- 分布式通信:由于门和专家分散,因此组件之间必须有高效的通信。数据被拆分并路由到正确的门,然后门将正确的数据传递给选定的专家。这种分散式结构允许并行处理,可以同时处理多个任务。

本地决策:在分散式 MoE 中,决策是在本地进行的。每个门独立决定针对给定输入激活哪些专家,而无需等待中央协调者。这使得系统能够有效扩展,特别是在大型分布式环境中。

去中心化 MoE 优势

分散式 MoE 系统通过将任务分布在多个门和专家之间,减少对中央协调员的依赖,提供可扩展性、容错性、效率、并行性和更好的资源利用率。

以下是 dMoE 系统的各种优势:

- 可扩展性:分散式 MoE 可以处理更大、更复杂的系统,因为它可以分散工作量。由于决策是在本地进行的,因此您可以添加更多门和专家,而不会使中央系统超载。这使得它非常适合解决分布式计算或云环境中的大规模问题。

- 并行化:由于系统的不同部分独立工作,dMoE 允许并行处理。这意味着您可以同时处理多个任务,速度比传统的集中式模型快得多。这在处理大量数据时尤其有用。

- 更好的资源利用率:在去中心化系统中,资源得到更好的分配。由于专家只在需要时才被激活,因此系统不会将资源浪费在不必要的处理任务上,从而提高能源和成本效率。

- 效率:通过将工作分摊到多个门和专家,dMoE 可以更高效地处理任务。它减少了对中央协调器管理一切的需求,这可能会成为瓶颈。每个门只处理其所需的专家,这加快了流程并降低了计算成本。

- 容错性:由于决策是分布式的,因此即使某个部分出现故障,系统也不太可能出现故障。如果一个门或专家出现故障,其他门或专家仍可继续独立运行,因此整个系统仍可正常运行。

MoE 与传统模型

传统模型使用单一网络执行所有任务,速度较慢且效率较低。相比之下,MoE 通过为每个输入选择特定专家来提高效率,使其速度更快,更适合复杂数据集。

以下是对两者的比较总结:

MoE 在人工智能和区块链中的应用

在人工智能中,MoE 模型主要用于增强深度学习模型的效率和性能,特别是在大规模任务中。

MoE 背后的核心理念是,它不是训练单个整体模型,而是训练多个“专家”模型,每个模型专注于任务的特定方面。系统会根据输入数据动态选择要使用哪些专家。这使得 MoE 模型能够有效扩展,同时实现专业化。

以下是一些关键的应用程序:

- 自然语言处理 (NLP): MoE不会使用单一的大型模型来处理语言理解的所有方面,而是将任务分派给专门的专家。例如,一位专家可以专注于理解上下文,而另一位专家则专注于语法或句子结构。这样可以更有效地利用计算资源,同时提高准确性。

- 强化学习:多方位专家技术已应用于强化学习,其中多位专家可能专注于不同的政策或策略。通过结合使用这些专家,AI 系统可以更好地处理动态环境或解决单个模型难以解决的复杂问题。

- 计算机视觉:计算机视觉领域也在探索 MoE 模型,不同的专家可能会专注于不同类型的视觉模式,例如形状、纹理或物体。这种专业化有助于提高图像识别系统的准确性,尤其是在复杂或多变的环境中。

区块链中的 MoE

虽然 MoE 与区块链的交集可能不像在人工智能中那样明显,但 MoE 仍然可以在区块链技术的多个方面发挥作用,特别是在优化智能合约和共识机制方面。

区块链是一种去中心化、分布式账本技术,无需中介即可实现安全透明的交易。以下是 MoE 应用于区块链的方式:

- 共识机制:工作量证明 (PoW) 或权益证明 (PoS)等共识算法可从 MoE 技术中获益,尤其是在管理不同类型的共识规则或验证者时。使用 MoE 将各种资源或专业知识分配给区块链验证流程的不同部分可以提高可扩展性并降低能耗(尤其是在 PoW 系统中)。

- 智能合约优化:随着区块链网络规模的扩大,智能合约的复杂性会变得繁琐。可以应用 MoE 来优化这些合约,允许不同的“专家”模型处理特定操作或合约类型,从而提高效率并减少计算开销。

- 欺诈检测和安全:可以利用 MoE 来增强区块链平台的安全性。通过利用专业专家来检测异常、恶意交易或欺诈,区块链网络可以从更强大的安全系统中受益。不同的专家可以专注于交易模式、用户行为甚至加密分析来标记潜在风险。

- 可扩展性:区块链可扩展性是一项重大挑战,而 MoE 可以通过在专业专家之间分配任务来提供解决方案,从而减少任何单个组件的负载。例如,不同的区块链节点可以专注于区块链堆栈的不同层,例如交易验证、区块创建或共识验证。

去中心化教育部门带来的挑战

去中心化 MoE 是一个令人兴奋但尚未得到充分探索的概念,尤其是将去中心化原则(如区块链)与专业 AI 模型(如 MoE)相结合时。虽然这种组合具有潜力,但它也带来了一系列需要解决的独特挑战。

这些挑战主要涉及协调、可扩展性、安全性和资源管理。

- 可扩展性:在分散的节点上分配计算任务可能会造成负载不平衡和网络瓶颈,从而限制可扩展性。高效的资源分配对于避免性能下降至关重要。

- 协调与共识:确保有效路由输入和分散专家之间的协调非常复杂,尤其是在没有中央权威的情况下。共识机制可能需要适应处理动态路由决策。

- 模型聚合和一致性:管理分布式专家之间更新的同步和一致性可能会导致模型质量和容错问题。

- 资源管理:在不同的独立节点之间平衡计算和存储资源可能会导致效率低下或过载。

- 安全和隐私:去中心化系统更容易受到攻击(例如Sybil 攻击)。在没有中央控制点的情况下保护数据隐私和确保专家诚信是一项挑战。

- 延迟:由于需要节点间通信,分散式 MoE 系统可能会遇到更高的延迟,这可能会妨碍实时决策应用。

这些挑战需要在去中心化 AI 架构、共识算法和隐私保护技术方面提供创新解决方案。这些领域的进步将是使去中心化 MoE 系统更具可扩展性、更高效和更安全的关键,确保它们能够在分布式环境中处理日益复杂的任务。

文章标题:什么是去中心化专家组合 (MoE)?

文章链接:https://www.btchangqing.cn/667003.html

更新时间:2024年11月15日

本站大部分内容均收集于网络,若内容若侵犯到您的权益,请联系我们,我们将第一时间处理。