原创:乔布斯

来源:

北京时间6月6日凌晨,苹果WWDC 2023全球开发者大会正式开幕,本次活动,作为“One more thing”登场的Apple Vision Pro无疑成为了活动最受关注的产品,没有之一。

就在行业内普遍认为“元宇宙”热潮退去,苹果杀入XR赛道有些姗姗来迟,结果反手却掏出Apple Vision Pro这样的“王炸”级产品,让行业颇为惊叹。

那么,在行业普遍将关注点转向人工智能,苹果才推出“元宇宙”设备Apple Vision Pro,不由得让人怀疑苹果在人工智能方面能力几何。

接下来就让大模型之家,为您盘点一下WWDC 2023上,全新的Apple Vision Pro,究竟都透露了苹果哪些人工智能实力?

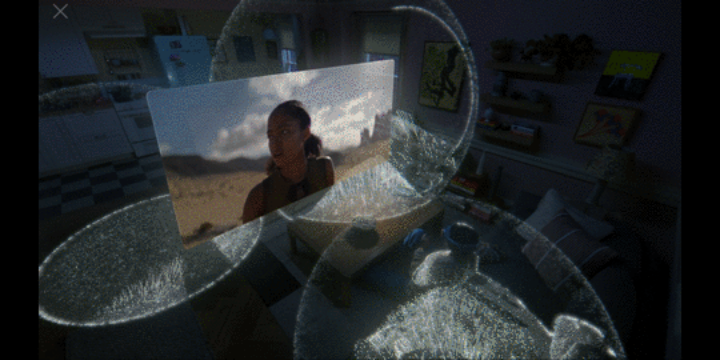

AIGC生成人像

在使用Apple Vision Pro进行FaceTime视频通话时,由于没有朝向用户的摄像头,而用户佩戴XR设备,也会让用户看上去非常奇怪。

为此,苹果通过Apple Vision Pro前置镜头扫描人脸信息,基于机器学习技术,系统会使用先进的编码神经网络,为用户生成一个“数字分身”,并动态模仿用户的面部和手部的动作,甚至可以保留数字分身的体积感和深度。使用的简易性和效果甚至超越了目前市面上的一部分数字分身软件。

更加智能的输入法

众所周知,XR行业目前最受诟病的困局之一,便是输入方式的匮乏,无论是手柄的单键输入,还是浮空键盘的输入方式,在效率与精度上,相比实体键盘,体验都十分糟糕。

而Apple Vision Pro主要互动方式为眼神、手势和语音,这就意味着语音输入可能将成为Apple Vision Pro最主要的键入方式之一。

虽然苹果并没有在Apple Vision Pro介绍中强调输入法,但是在iOS 17的介绍中则提到了更加智能的输入法,不仅可以纠正拼写错误,甚至还可以纠正用户在输入过程中的语法错误。

自动更正的单词会被临时下划线标记,让用户清晰地知道哪些单词被更改了,并且只需轻触一下即可恢复到原始单词。

更为重要的是,基于设备端的机器学习,输入法还会根据用户每一次的键入自动改进模型。将输入法的自动纠正功能达到了前所未有的准确度。

此外,基于最前沿的单词预测Transformer语言模型,单词联想功能 可以非常快速地输入下一个词,甚至是完整的句子。

而这种极为个性化的语言预测模型,也可以让输入法更加了解用户的语言习惯,也能在用户使用语音,输入的时候大幅提高输入的准确性。

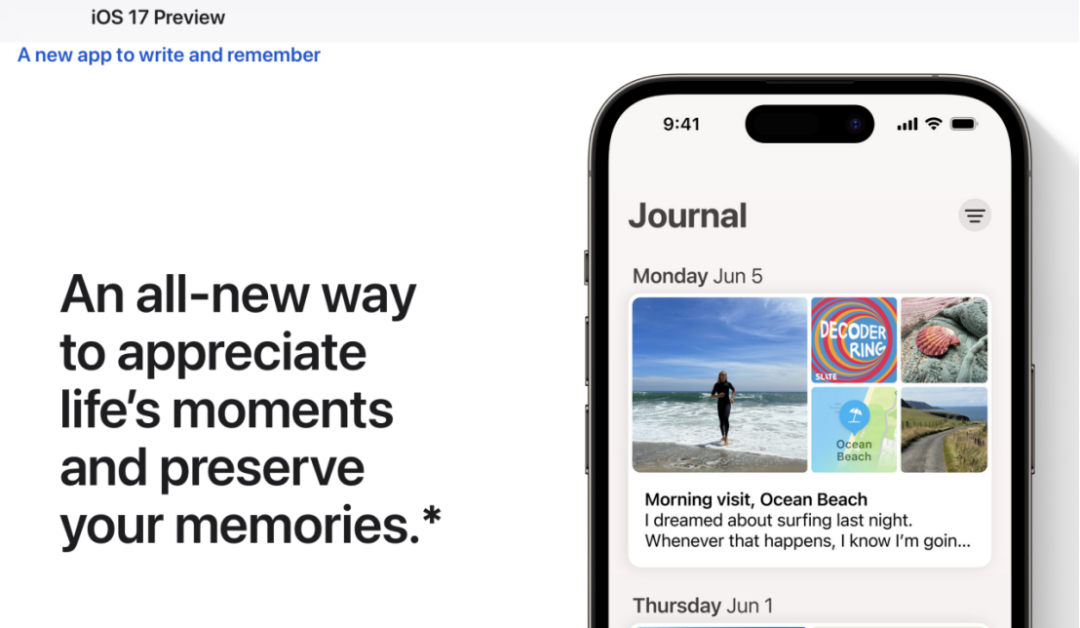

全新的“手记”APP

伴随iOS 17发布的,还有全新的“手记(Journal)”App,能够利用设备上的机器学习技术,根据用户的照片、音乐、锻炼等信息为您创建个性化的回忆和写作建议。App会根据这些信息为您提供适合您的时刻进行记录和书写的建议。

这意味着基于iPhone的算力,设备已经能够部署本地化处理文字、图片等多媒体内容的语义理解能力,同时具备一定的生成式AI功能。

而此时苹果选择低调,在大模型之家看来,面对GPT这样的**大模型,苹果的AI能力确实相对薄弱,过分强调AI能力无疑是以卵击石。

另外,作为一家主要营收来自于消费电子以及服务的科技公司,相对于AI这种相对笼统的概念,苹果更需要强调的是新功能的出现,对于用户体验的提升,持续增加用户的黏性。

场景与动作识别能力

除此之外,例如空间音频的计算、眼球动作以及手部行为的捕捉,这些也是人工智能技术所发力的领域,苹果凭借着M2和R1两颗芯片提供的算力支撑,实现了人工智能顺利的本地化部署,充分体现了苹果在消费电子领域人工智能应用的能力。

尽管在WWDC 2023上,苹果并未过度强调其AI能力,但从产品功能的方方面面来看,其AI能力却已经深入渗透到其产品的各个细节中,成为改进用户体验的重要手段。

作为全球**影响力的科技公司之一,尽管苹果没有过多宣传其在人工智能方面的成就,但从苹果擅长一鸣惊人的产品风格来看,其在人工智能领域的实力仍然不容小觑。

近期活动

个

阅读 987

写下你的留言

文章标题:Apple Vision Pro“泄漏”了苹果哪些AI能力?

文章链接:https://www.btchangqing.cn/540309.html

更新时间:2023年06月06日

本站大部分内容均收集于网络,若内容若侵犯到您的权益,请联系我们,我们将第一时间处理。