C/V/技/术/指/南

Computer Vision

论文原称

Long-term Temporal Convolution for Action Recognition(2017)

1.提出长期时间卷积网络(LTC)

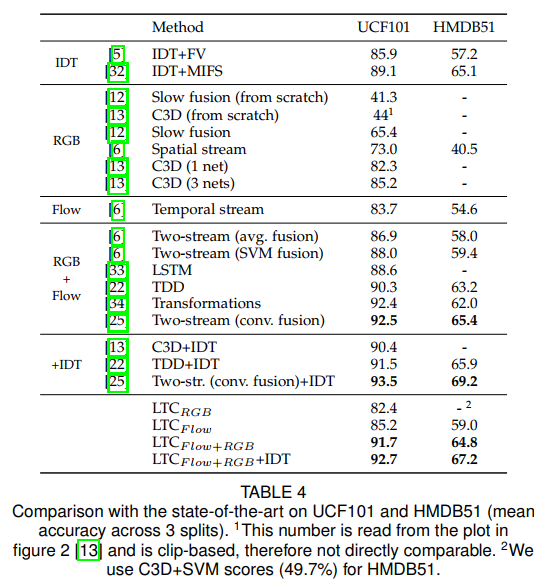

2.实现了在UCF-101(92.7%)和HMDB51(67.2%)数据集上行人动作识别的SOTA结果

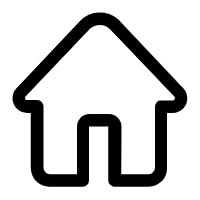

作者认为将视频分成短片段并通过利用每个片段的得分来整合视频级的信息,或者更复杂的方案像LSTM,都可能是次优的。因此作者提出长期的时间卷积网络(LTC),即采用更长的时间片段作为输入,但为了降低计算量,LTC模把空间上的分辨率缩小了。论文中,作者对时间片段的长短,空间分辨率的大小各自做了效果对比。

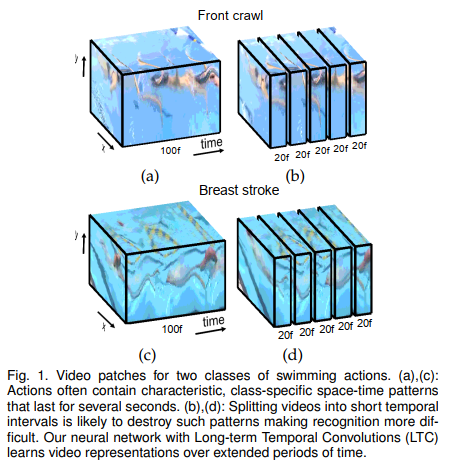

如图所示,网络由五层卷积网络,三层全连接层组成,卷积层的大小分别为64,12,8,256,256,256, 全连接层的大小分别为2048, 2048 ,n_classes。每个卷积层使用3x3x3的时空卷积核(与2D卷积核相比,不同之处在于多出的那一维是在时间维度上每次移动stride进行卷积),每个卷积层后接ReLU层,再接时空**池化层(与卷积同理,每次在时间维度上移动stride进行池化),除了第一层是2x2x1以外,其他每层ReLU层后的时空**池化层大小为2x2x2。在3个维度上的padding都是1。卷积的步长都是1,池化的步长都是2。在前两个全连接层使用dropout.网络**使用softmax计算类别分数。

模输入:

作者基于C3D模,比较了输入16帧和60帧的效果,其中输入的16帧的分辨率为112×112(其原来分辨率为171×128),输入的60帧的分辨率为58×58(是从视频原大小缩放到89×67后随意裁剪出58×58),因此两个输入的大小分别为112x112x16和58x58x60。

如图2所示:60帧输入的网络在时间维度上五个卷积层对应的分辨率分别为60,30,15,7,3,而16帧输入的网络在时间维度上五个卷积层对应的分辨率分别为16,8,4,2,1。因此在第五层卷积输出后16帧和60帧网络各自的分辨率为1x1x3,和3x3x1。作者还评估了时间维度上不同的分辨率的效果,t取{20,40,60,80,100},以及空间分辨率取{58×58, 71×71}。

论文主要的贡献就是提出LTC,本文介绍了其模结构,输入的一些细节,此外,论文里提到了一些其他的训练细节,如除了输入尺寸不同以外,还实验了RGB和光流分别作为输入的效果,对比固定一些层,只对fc层进行finetune和from-scratch的效果对比等。这些都不是创新点,算是每篇论文都会提到的东西,这里就不多提了。

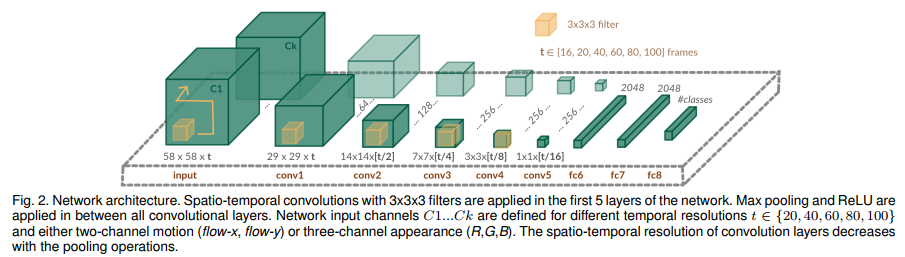

图a显示了不同长度片段的整体片段精度变化,说明片段长度越长,片段精度整体都更高。

图b显示了不同长度片段的整个视频的精度变化。图b说明,整体上视频的精度会随着片段长度的增加而提高,但部分会降低。

图c显示了每个类别随着片段长度的增加的精度变化,说明了部分类的行为会随着输入片段长度的增加而提高,部分在提高后又下降。

图d显示了不同输入片段长度下,能达到很高精度的行为类别的数量。说明整体上大部分行为的很高识别精度在片段长度较大时取到。

部分行为类别在输入片段长度增加后反而降低的一个可能的原因是这部分行为是一个比较短的动作。因此作者得出的结论是比较短的动作适合输入比较短的视频片段,而长的动作需要输入长的片段,但没办法下一个定论取哪个长度**。

上图是LTC模与其他SOTA模的效果对比。

如有错误,欢迎在公众号中留言指出

往期推荐

iDT:使用增强轨迹的行为识别

用于行为识别的密集轨迹和运动界限描述子

使用增强运动向量CNNs的实时行为识别

C3D:视频分析的通用特征

用于视频行为识别的双流卷积网络

您的关注是我更新的动力

长按识别二维码关注我们

本公众号主要进行CV论文解读,新技术跟踪,CV技术总结

文章:CV技术指南原创

文章标题:用于动作识别的长期时间卷积(LTC)

文章链接:https://www.btchangqing.cn/129907.html

更新时间:2020年10月26日

本站大部分内容均收集于网络,若内容若侵犯到您的权益,请联系我们,我们将第一时间处理。